Açıklanabilir Yapay Zekâ’da SHAP ve ELI5 Kullanımı

Açıklanabilir Yapay Zekâ (XAI) konulu yazımızın ilk bölümünde XAI’nın ne olduğunu, faydalarını ve zorluklarını ele almış, ayrıca LIME kütüphanesini nasıl kullanabileceğimizi örneklerle göstermiştik. Şimdi, XAI dünyasında LIME’ın etkileyici özelliklerini ele aldığımız ilk bölümün ardından, ikinci kısımda açıklanabilirlik alanında başka güçlü araçlara yöneleceğiz. SHAP ve ELI5 kütüphaneleriyle XAI yolculuğumuzu daha da derinleştiriyoruz. Bu kütüphaneler, açıklanabilir yapay zekâ alanına önemli katkılar sunmakta ve farklı bir perspektif sağlamaktadır. Şimdi, SHAP ve ELI5 kütüphanelerinin ne olduğunu, nasıl kullanıldığını keşfetmek için birlikte ilerleyelim.

SHAP

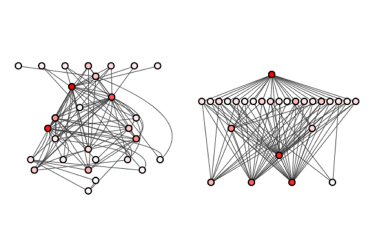

SHAP (Shapley Additive Explanations), 2017 yılında yayınlanmış ve herhangi bir makine öğrenimi modelinin çıktısını açıklamak için kullanılan bir açıklanabilirlik kütüphanesidir. Shap, Shapley değerleri olarak bilinen bir matematiksel kavramı kullanarak, makine öğrenimi modellerinin her özelliğinin tahmin üzerindeki etkisini hesaplar.

Shapley değeri, tanım olarak her özellik değeri için özellik uzayındaki tüm olası değerler boyunca ortalama marjinal katkıdır. Yani, bir özellik, model tahminindeki değişimde diğer tüm özelliklerle birlikte nasıl katkıda bulunuyorsa, Shapley değeri bu katkının ölçüsüdür. Pozitif Shapley değeri, tahmin üzerinde pozitif etki anlamına gelirken negatif Shapley değeri, negatif etki anlamına gelir. Bu yaklaşım, oyun teorisi kavramı olan Shapley değerlerine dayanır ve Lloyd Shapley tarafından 1952 yılında ortaya atılmıştır.

Bir örnek ile ifade edecek olursak: Bir banka, müşterilerine kredi vermeye karar verirken birçok faktörü göz önünde bulundurur. Bu faktörler arasında müşterinin kredi skoru, gelir durumu, borç oranı, iş durumu ve daha birçok özellik yer alır. Bu özellikler, bankanın müşteriye ne kadar riskli bir kredi verip veremeyeceğini belirlemede büyük rol oynar. Banka, müşterilerine daha doğru kredi kararları vermek için bir makine öğrenmesi modeli kullanabilir.

Güzel bir kullanım senaryosu şu şekilde verilebilir: Bir müşteri kredi başvurusu yapar ve başvurusu reddedilir. Müşteri, nedeninin ne olduğunu öğrenmek ve gelecekteki başvurularını iyileştirmek için bankanın karar sürecini anlamak isteyebilir. Bu noktada Shapley değerleri devreye girer. Her özelliğin, kredi başvurusunun reddedilmesindeki katkısını belirleyerek, modelin neden bu kararı verdiğini açıklamak mümkündür.

Örneğin, modelin kredi başvurusunu reddetme nedeni, müşterinin yüksek borç oranı olabilir. Shapley değerleri kullanılarak, modelin diğer özelliklere göre borç oranına daha fazla önem verdiği tespit edilebilir. Banka, müşteriye bu bilgiyi sağlayarak, gelecekteki başvurularında borç oranını düşürmesi gerektiğini belirtebilir. Bu, müşterilerin daha iyi kredi başvuruları yapmalarına ve bankanın müşteri memnuniyetini arttırmasına yardımcı olabilir.

Bu nedenle, SHAP, bir makine öğrenimi modelinin nasıl çalıştığını anlamamıza yardımcı olur ve açıklanabilirliği artırır. Modelin karar verme sürecindeki her bir özellik için önemini ve katkısını anlamamızı sağlar. Böylece, modelin güvenilirliğini artırır ve modelin ayrımcılık yapmasına neden olabilecek faktörleri belirlememize yardımcı olur.

Shap Çalışma Mantığı

Shap’in, bir özellik değerinin tahmin üzerindeki katkısını hesaplamak için Shapley değerleri adı verilen bir matematiksel kavramı kullandığından yukarıda bahsetmiştik. Shapley değeri, özellik değerlerinin her bir permütasyonu için tahminin farkını hesaplayarak belirlenir. Özellik değerlerinin her bir permütasyonu, modelin tahminlerindeki farklılık oranını hesaplamak için kullanılır. Bu farklılık oranları, her özellik için Shapley değerini hesaplamak için bir ağırlık olarak kullanılır.

Yukarıda verdiğimiz örnek üzerinden gidersek, bir müşterinin kredi alıp alamayacağı konusunda kredi skoru, yaş ve meslek şeklinde 3 özellik belirleyelim. Bu modelin bir veri örneği için tahmin değeri 0- 1 skalası üzerinden 0.8 olsun. “Kredi Skoru” özelliği “1500”, “Yaş” özelliği 25 ve “Meslek” özelliği “öğrenci” olarak belirlendiğinde, Shapley değerleri şu şekilde hesaplanır:

- “Kredi Skoru” özelliğinin Shapley değeri, “Kredi Skoru” özelliğinin “1500” olarak belirlenmesiyle yapılan tahmin ile “Kredi Skoru” özelliğinin “900” olarak belirlenmesiyle yapılan tahmin farkının ortalamasıdır.

- Aynı şekilde “Yaş” özelliğinin Shapley değeri, “yaş”ın 25’ten 30’a artırılmasıyla yapılan tahmin farkının ortalamasıdır. Bu farklar, “yaş”ın diğer özelliklerle birlikte modelin tahminindeki etkisini ölçmek için kullanılır.

Bu 3 özelliğin değerlerinin permütasyonları oluşturulur. Bu permütasyonların her biri için modelin tahmin ettiği değerler arasındaki fark hesaplanarak, her bir özelliğin Shapley değeri hesaplanır. Aşağıdaki formül [1], bir özelliğin Shapley değerini hesaplamak için kullanılır:

Formüle daha yakından baktığımızda;

i, özellik vektöründeki her bir özelliği,

n, toplam özellik sayısını,

N, n tane özelliğin mümkün olan tüm permütasyonlarını,

S, N kümesinin bir kümesini,

v(s), S kümesininin katkısını hesaplayan fonksiyonu ifade etmektedir.

Burada N\{i} ifadesi shapley değeri hesaplanan i özelliğinin dışındaki permütasyonlar anlamına gelir.

ifadesi belirli bir permütasyonun olasılık hesaplamasıdır.

ise i özelliğinin S kümesine olan marjinal katkısını verir.

Shap Grafik Örnekleri

Shap ile birlikte bir modelin her bir özelliğinin çıktıya olan etkisini açıklamak için farklı chartlar kullanılabilir.

Bu grafikte, tüm veri öznitelikleri tek bir grafikte kolayca anlaşılabilir görselleştirmelerle sunulur. Summary Grafiği, belirli bir özelliğin tahmine daha yüksek veya daha düşük etki edip etmediğini açıklamak için kullanılabilir.

Summary Grafiği yorumlamak için, her bir özellik için renk skalasına bakmanız gerekiyor. Daha koyu renkler, daha yüksek değerleri temsil ederken, daha açık renkler daha düşük değerleri temsil eder. Bu renkler, her bir özelliğin çıktıya olan etkisini gösterir. Örneğin, bir müşterinin kredi başvurusu reddedildiğinde, Summary Grafiğindeki “kredi skoru” özelliğinin daha koyu bir renge sahip olduğunu görebilirsiniz, bu da bu özelliğin reddetme kararında daha büyük bir etkiye sahip olduğunu gösterir.

2) Dependence Grafiği

Dependence Grafiği, tek bir özellik için SHAP değerinin özellik değerine karşı dağılım (scatter) grafiğidir. Bu grafik hedef değişken kümesinde oluşan her tahmin örneğini içerir. Yukarıdaki ilk görsele baktığımızda, SHAP değerlerinin özellik değeri ile doğrusal olarak arttığını görebiliriz. Ayrıca x ekseninin hemen üstünde yer alan histogram da değişken değerlerinin dağılımını göstermektedir.

Ayrıca Dependence Grafiği bir özellik ile diğer özelliğin karşılaştırılması için de kullanılabilir. Bununla birlikte, iki farklı renkte SHAP değerleri vurgulanarak iki özellik arasındaki etkileşim gösterilir.

Bu grafik, bir özelliğin çıktıya olan etkisini, diğer bir özellik değiştiğinde nasıl değiştiğini anlamak için kullanılır. Örneğin, SHAP Dependence Grafiğini kullanarak, iki özelliğin birlikte ne kadar önemli olduğunu anlayabilirsiniz. İkinci görsel ile birlikte analiz edilen iki özellik değeri büyüdüğünde SHAP değerlerinin de yüksek olduğu çıkarımını yapabiliriz.

3) Force Grafiği

Force Grafiği, satır bazlı SHAP değerlerini analiz etmek istediğinizde kullanabileceğiniz bir grafiktir. Bu grafik, bir satırdaki özellikleri ve bu özelliklerin sıralamasını gösterir ve böylece o satırdaki tahminin nasıl etkilendiğini anlamanıza yardımcı olur. Örneğin Şekil 3’te de görüldüğü üzere, binary sonucu olan bir modeli ele aldığımızda 0 değerinin “evet”, 1 değerinin ise “hayır” sonucunu temsil ettiğini varsayalım. Yukarıdaki grafikte de gördüğümüz 0.75 sayısı model skorumuzdur. Kırmızı renkli olan özellikler model skorunun daha yüksek olmasına, mavi renkli olanlar ise daha düşük olmasına sebep olur. Sonuca etkisi daha çok olan özellikler 0.75 sınıra daha yakın olurlar. Ayrıca barın boyutu bu etkinin büyüklüğü ile doğru orantılıdır.

Shap Nasıl Kullanılır?

Şimdi, SHAP kütüphanesi kullanarak tahmin açıklamaları oluşturmanın adımlarını açıklayalım.

- SHAP kütüphanesinin kurulumu

SHAP kütüphanesini yüklemek için pip veya conda kullanabilirsiniz. Bu örneklerde pip kullanacağız:

2. Model eğitimi ve veri kümesi hazırlama

SHAP kütüphanesini kullanmadan önce, bir model eğitmeniz ve bir veri kümesi hazırlamanız gerekir. Bu örnekte, bir Random Forest Regressor modeli kullanacağız ve “California Housing” veri kümesiyle çalışacağız. Modelin hedef değişkeni ise Kaliforniya bölgesi için ev ücretidir. Veri kümesi fetch_california_housing() fonksiyonuyla direkt olarak sklearn kütüphanesinden alınır, “train_test_split()” fonksiyonu kullanılarak %80 eğitim ve %20 test verileri olacak şekilde bölünür. Ardından, RandomForestRegressor() fonksiyonu kullanılarak varsayılan bir Random Forest Regressor modeli oluşturulur ve model, eğitim verilerine uygun hale getirilir.

Böylece, SHAP kütüphanesi kullanılarak modelin tahminlerinin nasıl açıklanabileceği için bir temel model hazırlanmış olur. Bir sonraki adım için Shap ve model eğitimi için gerekli olan diğer kütüphaneleri de import etmeliyiz.

3. SHAP Explainer’larının oluşturulması

SHAP kütüphanesi, veri kümesindeki her bir gözlem için bir SHAP değeri hesaplar. Bunun için, SHAP Explainer objeleri oluşturmanız gerekir. SHAP Explainer, SHAP değerlerini hesaplamak için kullanılan bir araçtır. Bu örnekte, bir Tree Explainer kullanacağız.

4. SHAP değerlerinin hesaplanması

SHAP Explainer oluşturulduktan sonra, her bir gözlem için SHAP değerlerini hesaplamak için shap_values yöntemini kullanabilirsiniz.

explainer.shap_values(X) ifadesi, X veri kümesindeki her bir örneğin SHAP değerlerini hesaplar. Bu hesaplama, modelin özellikleri nasıl kullandığını, hangi özelliklerin tahmin sonucunda daha fazla veya daha az önemli olduğunu ve bu özelliklerin belirli bir örnekteki tahmin sonucunu nasıl etkilediğini anlamak için kullanılabilir.

shap_values değişkeni, özelliklerin her bir örnekteki tahmin sonuçları üzerindeki etkilerini içeren bir dizi SHAP değerlerini içerir. Bu değerler, özelliklerin tahmin sonucuna olan katkısını anlamak için kullanılabilir ve grafiksel olarak görselleştirilebilir.

5. Tahmin açıklamalarının ve Modelin özellik önemlerinin görselleştirilmesi

SHAP kütüphanesi, tahmin açıklamalarını görselleştirmek için çeşitli grafikler sağlar. Örneğin, bir Bar Grafiği kullanarak, belirli bir örnek için bir modelin neden belirli bir tahmin yaptığını anlayabilirsiniz ya da bir Summary Grafiği kullanarak, her bir özellik için görselleştirme yapılabilir.

Şekil 4’teki Grafik ile özelliklerin tahmin sonucuna olan etkileri, mutlak SHAP değerlerine göre sıralanır. Bu sıralama, özelliklerin tahmin sonucuna olan etkisini daha net bir şekilde anlamamıza yardımcı olur. En yüksek etkiye sahip özellikler, tahmin sonucuna daha fazla katkıda bulunurken, en düşük etkiye sahip özellikler, tahmin sonucuna daha az katkıda bulunur. Örneğin, Şekil 4’ten de görüldüğü gibi Hane geliri anlamına gelen MedInc özelliği en yüksek mutlak shapley değerine sahiptir. Bu, hane gelirinin ev fiyatının tahminlenmesinde katkısının en çok olduğunu gösterir.

Summary grafiği, her bir gözlemi temsil eden küçük noktaları içeren bir grafiktir. Bu grafikte, yatay eksende SHAP değerleri gösterilirken, noktanın rengi, o gözlemin özelliğinin diğer gözlemlere göre yüksek veya düşük bir değere sahip olup olmadığını göstermektedir.

Şekil 5’teki Grafik incelendiğinde, örneğin, daha yüksek değere sahip enlem ve boylam değerleri tahmin sonucunu olumsuz yönde etkileyerek ev fiyatını düşürürken, daha düşük değere sahip olanlar ise olumlu yönde etkileyerek ev fiyatını yükseltmektedir. Bu şekilde, Summary grafiği, her bir özelliğin tahmin sonucuna olan etkisini anlamamıza ve farklı özellik değerlerinin sonuca nasıl etki ettiğini görselleştirmemize yardımcı olur.

Waterfall grafiği, yalnızca bir tahmin için her özelliğin katkısını ayrı ayrı gösteren bir grafiktir. Görsel olarak Şekil 6’da görüldüğü üzere, Waterfall grafiği, bir şelaleye benzer. Bir Waterfall grafiğinin alt kısmı, model çıktısının Expected Value’sunu (beklenen değer) yani başka bir deyişle veri setindeki ortalama tahmin değerini gösterir. Bu değer, baz değer olarak geçer ve her bir tahmin için aynıdır. Ardından gelen her satır ise, her bir özelliğin pozitif (kırmızı) veya negatif (mavi) katkısının tahmine nasıl etkide bulunduğunu bize söyler.

Özellikler, SHAP değerlerinin büyüklüğüne göre sıralanır ve en küçük büyüklük özellikleri çizimin altında birlikte gruplanır.Büyük pozitif/negatif değerler, özelliğin modelin tahmininde önemli bir etkiye sahip olduğunu gösterir. Şekil 6’daki grafiğe bakıldığında, f(x) belirli bir durum için modelin tahmin ettiği ev fiyatıdır. Baz değer ve shapley değerlerinin toplamı ile bulunur. Bizim örneğimiz için baz değer 2.059, shapley değerlerinin toplamı da -0,93’tür. Bu iki değerin toplanması ile f(x) 1.124 olarak hesaplanmıştır. Örneğin, hane gelirinin 2.364 olmasının tahmin sonucuna katkısı -0.43 shapley değeri ile ifade edilmiştir. Bu ikinci en büyük katkıdır fakat olumsuz yönde etkileyerek ev ücretini düşürecek şekildedir.

ELI5

ELI5 (Explain Like I’m 5), makine öğrenmesi modellerinin tahminlerinde en önemli ve etkili faktörleri anlaşılır ve açıklanabilir bir şekilde sunarak, basit ve sezgisel bir dil ile açıklayan XAI yaklaşımıdır. Python dili için hazırlanmış ELI5 kütüphanesi, sklearn sınıflandırıcıları, XGBoost, CatBoost, LightGBM ve Keras gibi sınıflandırıcıların tahminlerini anlamak ve açıklamak için kullanılabilmektedir. Bu kütüphane, bu algoritmaların süreçlerine yönelik görselleştirmeler ve hata ayıklama gibi araçlar ve fonksiyonlar sunmaktadır. ELI5 metin işleme konusunda da uzmandır ve metin verilerini vurgulayabilir. Ayrıca, permütasyon önemliliği gibi teknikleri de uygulayabilir.

ELI5, makine öğrenmesi modellerinin ne kadar iyi çalıştığını anlamak için önemli bir araçtır. Bu sayede, modellerin tahminlerindeki belirleyici faktörleri açıklayarak, modellerin karar verme süreçlerini anlamak mümkün hale gelir. ELI5 aynı zamanda, modellerin ne kadar güvenilir olduğunu anlamaya yardımcı olabilir. Böylece, örneğin, bir sınıflandırıcı tarafından yapılan bir tahminin ne kadar güvenilir olduğu, ELI5 tarafından açıklanabilir.

ELI5’ın bir diğer avantajı, metin verileri üzerinde çalışırken kullanıcıların kolayca anlayabileceği bir şekilde verileri vurgulayabilmesidir. Örneğin, bir kelimenin veya cümlenin neden önemli olduğunu açıklayarak, bir metnin hangi kısımlarının belirleyici olduğunu açıklayabilir.

ELI5, makine öğrenmesi uygulamalarının şeffaflığını ve anlaşılırlığını artırarak, insanların bu teknolojileri daha iyi anlamalarına yardımcı olur. Ayrıca, ELI5 sayesinde, modellerin güvenilirliği ve etkili faktörleri daha iyi anlaşılarak, bu teknolojilerin güvenli ve adil bir şekilde kullanılması sağlanabilir.

ELI5 Nasıl Kullanılır?

Şimdi, ELI5 metodunu kullanarak tahmin açıklamaları oluşturmanın adımlarını açıklayalım.

- ELI5 kütüphanesinin kurulumu

ELI5 kütüphanesini yüklemek için pip paket yöneticisini kullanabilirsiniz. Bunun için, terminal veya komut istemi kullanarak şu komutu yazmanız yeterli olacaktır:

2. Model eğitimi ve veri kümesi hazırlama

Örnek bir uygulama yapmak için, Titanic veri setini kullanacağız. Bu veri seti, Titanic gemisindeki yolcuların çeşitli özelliklerini içermektedir. Özellikler arasında, yaş, cinsiyet, bilet sınıfı ve hayatta kalma durumu yer almaktadır. Amacımız, bu veri setini kullanarak bir yolcunun Titanic faciasından sağ kurtulup kurtulamayacağını tahmin etmektir.

Veri setini kullanabilmek için, Pandas kütüphanesini kullanarak veri setini bir DataFrame olarak yüklemeliyiz. Veri seti, sınıflandırıcı modelimizin özelliklerini (değişkenlerini) içerir. Modelimizi eğitmek ve modelin tahminlerini açıklamak için bu veri setini kullanabiliriz.

Makine öğrenmesi modelini oluşturmak için Scikit-Learn kütüphanesindeki Random Forest Classifier’ı kullanacağız. Öncelikle veri setimizi eğitim ve test veri setleri olarak ayırmalıyız. Bunun için, train_test_split fonksiyonunu kullanacağız. Veri setimizin “Survived” değişkeni, modelimizin tahmin etmeye çalışacağı hedef değişkenimizdir. Ardından, Random Forest Classifier’ı kullanarak modelimizi eğiteceğiz. Modelin eğitiminden sonra bu modelin kararlarını nasıl verdiğini anlamamız gerekmektedir. Bunun için de XAI’den yararlanacağız.

3. ELI5 Metotlarının Kullanımı

a) Öznitelik Önemi (Feature İmportance)

Öznitelik Önemi, bir makine öğrenimi modelinde hangi özelliklerin en önemli olduğunu anlamamıza yardımcı olan popüler bir XAI tekniğidir. ELI5, Öznitelik Önemini hesaplamak için explain_weights işlevini kullanarak basit bir yöntem sağlar. Titanic veri kümesi örneğiyle devam edelim.

Bununla birlikte, her bir özellik için Öznitelik Önemi skorlarını gösteren bir tablo elde ederiz. Bu skor bize bir özelliğin ortalama olarak tahminler üzerinde ne kadar etkisinin olduğunu, skorun işareti ise bu etkinin hangi yönde olduğunu söyler. Aşağıdaki tabloya göre, model üzerinde etkisi en çok olan durumun Kadın Cinsiyeti olduğunu, bunu Seyahat Sınıfı özelliğinin takip ettiğini söyleyebiliriz.

b. Permütasyon Önemi (Permutation Importance)

ELI5, bir modelin hangi özelliklerinin (değişkenlerin) tahminler üzerinde daha fazla etkisi olduğunu belirlemek için kullanılabilir. Bu analiz, permütasyon önemliliği yöntemi ile gerçekleştirilir. Bu yöntemde, her bir özellik rastgele karıştırılır ve modelin tahminleri yeniden hesaplanır. Bu işlem, her bir özelliğin ne kadar önemli olduğunu belirlemek için tekrarlanır.

Permütasyon Önemi, Öznitelik Önemi ile benzer bir tekniktir ancak her bir özellik için yeni bir model kurmak yerine her özelliği rastgele permütasyon yapıp, model performansındaki azalmayı ölçer. Bu bize, model performansı için en önemli özellikleri belirlemede yardımcı olabilir.

ELI5 ile permütasyon önemini hesaplamak için permutation_importance fonksiyonunu kullanabiliriz:

Bununla birlikte, her bir özellik için Permütasyon Önemi skorlarını gösteren bir tablo elde ederiz. Aşağıdaki tablonun weight kısmındaki ilk sayı, ilgili özelliğin rastgele karıştırılması(reshuffle) ile model performansının ne kadar azaldığını gösterir. Buradaki rastgeleliğin etkisi, birden fazla karıştırma işleminin tekrarlanması ile ölçülür. Özellik karıştırılması, bu özelliğin sırasının rastgele bir şekilde değiştirilmesi anlamına gelir. ± sembolünden sonra gelen sayı ise bu özellik için performans azalmasının farklı karıştırmalar için nasıl değiştiğini ölçer. Bazen ilk sayı negatif bir değer alabilir. Bu da karıştırılmış verilerdeki tahminlerin gerçek verilerden daha doğru olduğu anlamına gelir. Tablodan gördüğümüz gibi, cinsiyet ve yaş en önemli özellikler olarak belirlenmiştir.

c. Metinsel Açıklama (Textual Explanation)

ELI5 ayrıca makine öğrenimi modelleri için metinsel açıklamalar oluşturma araçları da sağlar. Metinsel açıklamalar, bir modelin belirli bir karar veya tahmine nasıl ulaştığını anlamamıza yardımcı olabilir. ELI5 kullanarak metinsel açıklama oluşturmak için, eğitilmiş bir model, bir veri örneği ve hedef sınıf (varsa) verilerek explain_prediction fonksiyonunu çağırabiliriz. Bu fonksiyon, modelin tahmininin metinsel bir açıklamasını çıktı olarak verir.

Fonksiyonun çıktısı, bir test örneği için modelin tahmin ettiği olasılık değeri olan kurtulma olasılığını ve tahminin yapılmasında kullanılan her bir feature ağırlığını içeren bir metin olarak görüntülenir. Burada modelin “female” cinsiyetinin kurtulma tahmini için iyi, seyahat sınıfının ise “Pclass=3” olmasının kötü olduğunu düşündüğünü görüyoruz.

Bu yazıda SHAP ve ELI5 kütüphanelerinin ne olduğunu, nasıl kullanıldığını ve açıklanabilir yapay zekâdaki rolünü ele aldık. Bu kütüphaneler, yapay zekâ modellerinin iç çalışma mekanizmalarını anlamamıza yardımcı olurken, aynı zamanda güvenilirliklerini artırarak kullanıcıların model kararlarını sorgulama ve anlama süreçlerine katkıda bulunurlar. Açıklanabilir yapay zekâ, gelecekteki yapay zekâ sistemlerinin daha şeffaf, hesap verebilir ve adil olmasını sağlama hedefimize önemli bir adımdır.

Kaynaklar

- Lloyd S. Shapley. A value for n-person games. In Robert Kuhn and Albert Tucker, editors, Contributions to the Theory of Games, pages 307–317. Princeton University Press, 1953.

- SHAP and LIME: Great ML Explainers with Pros and Cons to Both. (2022, February 14). Retrieved May 12, 2023, from https://www.dominodatalab.com/blog/shap-lime-python-libraries-part-1-great-explainers-pros-cons

- Korobov, M., & Lopuhin, K. (2016). Overview — ELI5 0.11.0 documentation. Retrieved May 15, 2023, from https://eli5.readthedocs.io/en/latest/overview.html

- Safjan, K. (2023, February 19). Understanding AI with ELI5 – Demystifying Decisions (tutorial). Krystian Safjan’s Blog. Retrieved May 13, 2023, from https://safjan.com/eli5-tutorial/

- Meena, P. (2022). Demystifying Model Interpretation using ELI5. Analytics Vidhya. Retrieved May 15, 2023, from https://www.analyticsvidhya.com/blog/2020/11/demystifying-model-interpretation-using-eli5/

- Trevisan, V. (2022, July 5). Using SHAP Values to Explain How Your Machine Learning Model Works. Medium. Retrieved May 12, 2023, from https://towardsdatascience.com/using-shap-values-to-explain-how-your-machine-learning-model-works-732b3f40e137

- Explainable AI (XAI) — A guide to 7 Packages in Python to Explain Your Models. (2021, December 14). Retrieved May 15, 2023, from https://towardsdatascience.com/explainable-ai-xai-a-guide-to-7-packages-in-python-to-explain-your-models-932967f0634b

Önceki

Önceki