Paradigmaların Gücü ve Tehlikesi

İnsanlık tarihi, yerleşik düşünce kalıplarının bilimsel ilerlemeyi nasıl geciktirdiğine dair örneklerle dolu. Antik çağ gökbilimcilerinin “kusursuz çember” inancı bunun en çarpıcı örneklerinden biri. Yüzyıllarca gezegenlerin dairesel yörüngelerde döndüğüne inanıldı; gözlemler uymayınca karmaşık epicycle modelleriyle açıklanmaya çalışıldı (Kuhn, 1962). Ancak Johannes Kepler, gezegenlerin eliptik yörüngelerde hareket ettiğini ortaya koydu. Bu bulgu, paradigmalara körü körüne bağlı kalmanın tehlikesini ve yeni bakış açılarının önemini gösterdi. Bugün yazılım test mühendisliği de benzer risklerle karşı karşıya; hele ki yapay zekâ çağında paradigma tuzakları daha görünmez ama daha güçlü şekilde karşımıza çıkıyor.

İnsan Zihninin Tuzakları: Psikolojik Kökenler

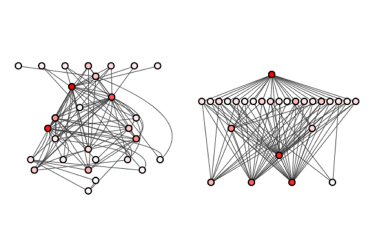

Psikoloji ve bilişsel bilim araştırmaları, insan zihninin hızlı karar verebilmek için kestirme yollar kullandığını ortaya koyuyor. Bu mekanizmalar birçok durumda avantaj sağlasa da (Kahneman, 2011), yazılım test mühendisliği gibi karmaşık alanlarda önyargıya dönüşebiliyor. Bilişsel ekonomi kavramı, beynin enerji tasarrufu amacıyla geçmişte işe yarayan düşünce kalıplarını otomatikleştirdiğini anlatır; bu, hız kazandırırken yeni çözümleri gölgeleme riski taşır (Kahneman, 2011). Belirsizlikten kaçınma eğilimi insanları, belirsiz durumlarda bile geçmiş deneyimlere dayanarak kestirimler yapmaya iter (Festinger, 1957). Evrimsel perspektiften bakıldığında ise atalarımız için hızlı ve sezgisel karar vermek hayatta kalma avantajı sağlamış; günümüzün karmaşık yazılım dünyasında ise aynı eğilim bilişsel önyargılara zemin hazırlayabiliyor (Tversky & Kahneman, 1974).

Yazılım Testinde Bilişsel Önyargılar

Test mühendisleri de bu zihinsel tuzaklardan kaçamıyor. İki önyargı özellikle kritik:

Confirmation Bias (Onaylama Yanlılığı). Bu eğilim, mevcut inançlarla uyumlu kanıtları arama ve bunlara daha fazla önem atama; uyumsuz kanıtları ise göz ardı etme eğilimidir (Nickerson, 1998). Örneğin; bir ödeme API’sinin performansını doğrulamak isteyen test mühendisi, yalnızca standart trafik altında test yaparsa yüksek yük altında ortaya çıkabilecek zafiyetleri görmezden gelebilir (Runeson & Andrews, 2012).

Selective Bias (Seçici Yanlılık). Test kapsamını yalnızca kolay gözlemlenebilen veya güvenli senaryolarla sınırlama eğilimidir (Felderer & Beer, 2015). Örneğin; mobil uygulama testlerini sadece en güncel ve güçlü cihazlarda yapmak, düşük donanımlı cihazlarda oluşabilecek kritik sorunları dışarıda bırakır. Bu iki önyargı birlikte çalıştığında, test süreçleri hem dar hem yanıltıcı senaryolara odaklanır ve nadir ama kritik durumlar kolayca atlanır (Tversky & Kahneman, 1974).

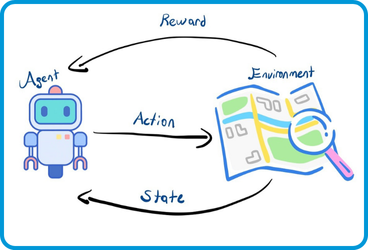

Yapay Zekâ ve GenAI Çağında Ölçeklenmiş Paradigma Hataları

Kasım 2022 öncesinde yapay zekâ tartışmaları büyük ölçüde makine öğrenmesi (ML) ve derin öğrenme (DL) çerçevesinde yürütülüyordu. Bu dönemde önyargılar genellikle eğitim verilerindeki dengesizlikler, azınlık sınıflarının yetersiz temsil edilmesi ve model kararlarının şeffaf olmaması etrafında ele alındı (Stolee & Robinson, 2020). Confirmation bias veya selective bias içeren veri kümeleri, test senaryolarında belirli koşulların öncelenmesine ve nadir senaryoların ihmal edilmesine neden oldu (Felderer & Beer, 2015).

Kasım 2022 sonrasında ise büyük dil modelleri (LLM) ve çok modlu üretken yapay zekâ (GenAI) araçlarının yaygınlaşmasıyla tartışmalar farklı bir boyuta evrildi. Artık yalnızca veri dağılımlarındaki bias’ler değil, aynı zamanda modellerin 'hallucination' üretmesi, kültürel önyargıları yeniden üretmesi, güvenlik açıkları (prompt injection, jailbreak) ve şeffaflık eksiklikleri gündemdedir (Bender et al., 2021; Weidinger et al., 2022).

Bu yeni dönemde bias problemleri daha görünmez fakat daha etkili hale gelmiştir. Örneğin, GenAI tabanlı test araçları yüzlerce test senaryosu üretebilmekte; fakat bu senaryolar, eğitim verisindeki önyargıları veya modelin kendi üretim hatalarını ölçekleyerek tekrar edebilmektedir. Bu durum, yazılım test mühendisliğinde önceden tekil insan hatalarıyla sınırlı kalan riskleri, kitlesel ve sistematik hale dönüştürür (Bommasani et al., 2023).

ISTQB Perspektifinde Bias ve Test Teknikleri

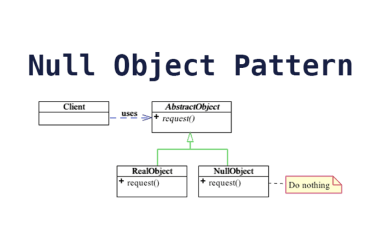

- ISTQB tarafından tanımlanan yazılım test tasarım teknikleri, önyargıların test mühendisliği üzerindeki etkisini daha somut biçimde görünür kılar. Bias’ler yalnızca teorik değil, doğrudan test kapsamını daraltan ve kritik hataların gözden kaçmasına yol açan pratik tehditlerdir. Özellikle şu teknikler dikkat çekicidir:

- **Sınır Değer Analizi (Boundary Value Analysis)**: Yazılım hatalarının önemli bir bölümü giriş aralıklarının sınırlarında ortaya çıkar. Confirmation veya selective bias ise test mühendislerini 'ortalama' senaryolara yönlendirerek sınır değerlerin göz ardı edilmesine neden olabilir (ISTQB, 2018). Bu durum en kritik hataların atlanması riskini doğurur.

- **Denklik Sınıfı Testi (Equivalence Partitioning)**: Giriş alanları mantıksal gruplara ayrılır ve her sınıftan temsilci değerlerle test yapılır. Ancak bilişsel önyargılar, bu denklik sınıflarının bütünlüklü görülmesini engelleyebilir; bazı sınıflar hiç test edilmez, bu da yazılımda kritik açıkların kalmasına neden olur (ISTQB, 2018).

- **Risk Tabanlı Test (Risk-Based Testing)**: Risklerin önceliklendirilmesi önyargılardan etkilenebilir. Daha görünür riskler abartılırken, düşük görünürlüklü ama kritik riskler ihmal edilebilir. Bu durum test kapsamını stratejik olarak dengesiz hale getirir.

Dolayısıyla ISTQB’nin önerdiği test teknikleri perspektifinden bakıldığında, bias yalnızca teorik bir problem değil, doğrudan test kapsamı, hata yakalama oranı ve yazılım kalitesi üzerinde ölçülebilir etkiye sahip kritik bir risk faktörüdür. Üstelik yapay zekâ çağında bu riskler yalnızca varlığını sürdürmekle kalmaz; ölçek etkisiyle katlanarak artma potansiyeline de sahiptir. Çünkü GenAI tabanlı araçlar tek bir önyargıyı yüzlerce, hatta binlerce test senaryosuna çoğaltabilir ve bu da insan kaynaklı önyargıların sistematik hale gelmesine yol açar.

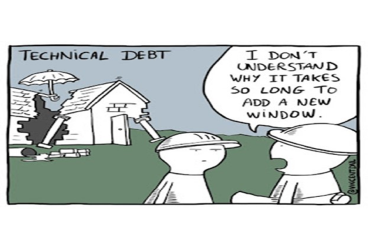

Paradigma Tuzaklarının Teknik Riskleri ve Güncel Tartışmalar

ML/DL modellerinde riskler daha çok dengesiz veriler, nadir senaryoların ihmal edilmesi ve açıklanabilirlik eksikliği etrafında toplanıyordu (Felderer & Beer, 2015). GenAI döneminde ise bu riskler farklılaşarak; hallucination oranlarının ölçümü, çıktının doğrulanabilirliği, güvenlik temelli manipülasyonlar (prompt injection) ve kültürel-etik önyargıların sistematik yeniden üretimi gibi boyutlar kazanmıştır (Weidinger et al., 2022).

Bu çıktıları ölçmek ve sınıflandırmak için henüz tam anlamıyla standartlaşmış bir metodoloji yoktur. Bununla birlikte literatürde bu yönde girişimler bulunmaktadır: fairness metrikleri (Demographic parity, Equal opportunity, Equalized odds), IEEE P7003 standardı, TruthfulQA (Lin et al., 2023), Hallucination Benchmark (Ji et al., 2023), RealToxicityPrompts ve Stanford CRFM’in HELM (2022) çerçevesi bunlardan bazılarıdır. Dolayısıyla standartlaşma eksikliği sürmekle birlikte, bu alandaki akademik çabalar test mühendisliğine uyarlanabilecek zengin bir temel sunmaktadır.

Öne çıkan bazı metrikler şunlardır:

- **Demographic Parity**: Çıktıların farklı gruplar arasında eşit dağılması.

- **Equal Opportunity**: Hata oranlarının gruplar arası eşitliği.

- **Calibration**: Model tahmin olasılıklarının doğruluğu.

- **Truthfulness / Hallucination Rate**: GenAI modellerinin yanlış bilgi üretme sıklığı.

- **Robustness Under Adversarial Prompts**: Zararlı veya manipülatif girdilere karşı dayanıklılık.

Bilimsel Yöntemden İlham: Poppercı Yaklaşım

Karl Popper’ın bilim felsefesinde öne koyduğu temel fikir, bilimin ilerlemesinin hipotezlerin çürütülmesine dayanmasıdır (Popper, 1959). Test mühendisliği bağlamında bu, senaryoları yalnızca doğrulamak için seçmemeniz; bilakis, mevcut varsayımları güçlü biçimde sınayacak uç ve beklenmedik durumları da kasıtlı şekilde dahil etmeniz gerektiği anlamına gelir. Runeson & Andrews (2012) ve diğer çalışmalarda belirtildiği gibi, test senaryolarını hipotezi çürütecek şekilde tasarlamak confirmation bias’ın etkisini azaltır. Keşifçi test (exploratory testing) yaklaşımı, Kaner, Bach & Pettichord’un çalışmasında olduğu gibi, Popper’ın çürütme ilkesinin pratikteki yansımasıdır; burada test mühendisi, formel senaryoların ötesine geçerek sistemin beklenmedik davranışlarını aktif biçimde arar (Kaner, Bach & Pettichord, 2002). AI destekli test ortamlarında da aynı ilke geçerlidir: AI’nın ürettiği senaryolar ve öngörüler doğrudan kabul edilmemeli; bunlar test mühendisi tarafından eleştirel bir süzgeçten geçirilmeli ve “Bu öneri hangi olasılıkları dışarıda bırakıyor?” sorusuna cevap aranmalıdır. Bu sorgulama sayesinde AI, pasif bir test destek aracı olmaktan çıkar ve insanın eleştirel değerlendirmesini güçlendiren aktif bir ortak haline gelir.

Paradigmasal Sorgulayıcı Yaklaşımın Önemi ve Zero Trust Perspektifi

Paradigmaları sorgulamak kolay değildir; zira yerleşik uygulamalar, süreçler ve kültürel beklentiler bu sorgulamayı zorlaştırır. Ancak yazılım test mühendisleri için artık bu sorgulama bir lüks değil, zorunluluk. Sürekli olarak “Neden bu şekilde test ediyoruz?” sorusunu sormak, sık kullanılan senaryoların dışına çıkmak ve AI’nın önerilerini eleştirel bir bakışla değerlendirmek gerekir. Bu yeti sadece teknik bir beceri değil; yapay zekâ çağında test mühendisliğinin en kritik soft skilllerinden biridir. Eleştirel sorgulama, hem insan kaynaklı hem de AI kaynaklı önyargıların sistematikleşmesini engeller ve yazılım kalitesini koruyan bilimsel bir sigorta işlevi görür.

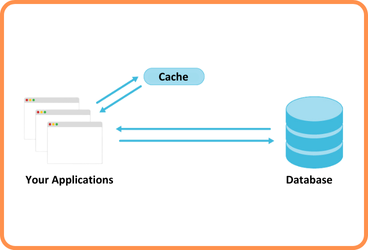

Zero Trust yaklaşımı, 'çıktıya koşulsuz güvenme' varsayımını reddeder. Test mühendisliğinde bu, AI veya GenAI tarafından üretilen her senaryonun bağımsız doğrulama süreçlerinden geçmesi gerektiği anlamına gelir. Böylece, Poppercı sorgulama ilkesi modern güvenlik paradigmasıyla birleşerek, AI destekli test süreçlerinin daha güvenilir ve sürdürülebilir olmasını sağlar (NIST, 2023).

Sonuç: Kepler’den AI Çağına Dersler

Kepler’in elipsleri, gökbilimde köklü bir paradigmayı yıktı çünkü o dönemki varsayımları sorgulamayı seçti. Yazılım test mühendisliği de benzer bir ders almak zorunda: varsayımlar sorgulanmadığında, hem insan hem de AI destekli test süreçleri görünmez hataları sürekli tekrar eder. Özellikle yapay zekâ araçlarının önyargıları çarpan etkisiyle pekiştirdiği günümüzde, paradigmasal sorgulayıcı yaklaşım bir soft skill olmanın ötesine geçer — yazılım kalitesinin bilimsel sigortası haline gelir.

Kaynakça

- Barocas, S., Hardt, M., & Narayanan, A. (2021). *Fairness and machine learning*. http://fairmlbook.org/

- Bender, E. M., Gebru, T., McMillan-Major, A., & Shmitchell, S. (2021). On the dangers of stochastic parrots: Can language models be too big? *FAccT 2021*. https://doi.org/10.1145/3442188.3445922

- Bommasani, R., Hudson, D. A., & Liang, P. (2023). Foundation models in the era of generative AI. Stanford HAI. https://hai.stanford.edu/

- Felderer, M., & Beer, A. (2015). Addressing cognitive bias in software quality assurance. *ICSTW 2015*. https://doi.org/10.1109/ICSTW.2015.7107469

- Festinger, L. (1957). *A theory of cognitive dissonance*. Stanford University Press.

- ISTQB. (2018). *Certified tester foundation level syllabus, version 2018*. https://www.istqb.org/

- Ji, Z., Lee, N., Fries, J., & Liang, P. (2023). Survey of hallucination in natural language generation. *ACM Computing Surveys, 55*(12), 1–38. https://doi.org/10.1145/3571730

- Kahneman, D. (2011). *Thinking, fast and slow*. Farrar, Straus and Giroux.

- Kaner, C., Bach, J., & Pettichord, B. (2002). *Lessons learned in software testing*. Addison-Wesley.

- Kuhn, T. S. (1962). *The structure of scientific revolutions*. University of Chicago Press.

- Lin, S., Hilton, J., & Evans, O. (2023). TruthfulQA: Measuring how models mimic human falsehoods. *TACL, 11*, 1–20. https://doi.org/10.1162/tacl_a_00407

- Nickerson, R. S. (1998). Confirmation bias: A ubiquitous phenomenon in many guises. *Review of General Psychology, 2*(2), 175–220. https://doi.org/10.1037/1089-2680.2.2.175

- NIST. (2023). *Zero trust architecture and generative AI*. National Institute of Standards and Technology. https://www.nist.gov/

- Popper, K. (1959). *The logic of scientific discovery*. Routledge.

- Runeson, P., & Andrews, A. (2012). Cognitive biases in software testing. *IEEE Software, 29*(5), 18–21. https://doi.org/10.1109/MS.2012.107

- Stanford CRFM. (2022). *HELM: Holistic evaluation of language models*. https://crfm.stanford.edu/helm

- Stolee, K. T., & Robinson, B. J. (2020). Bias in machine learning models and its impact on software testing. *Journal of Systems and Software, 170*, 110717. https://doi.org/10.1016/j.jss.2020.110717

- Tversky, A., & Kahneman, D. (1974). Judgment under uncertainty: Heuristics and biases. *Science, 185*(4157), 1124–1131. https://doi.org/10.1126/science.185.4157.1124

- Weidinger, L., et al. (2022). Taxonomy of risks posed by language models. *FAccT 2022*, 214–229. https://doi.org/10.1145/3531146.3533088

- IEEE. (2022). *IEEE P7003: Standard for algorithmic bias considerations*. IEEE Standards Association.

İlginizi Çekebilecek Diğer Blog Yazılarımız

-

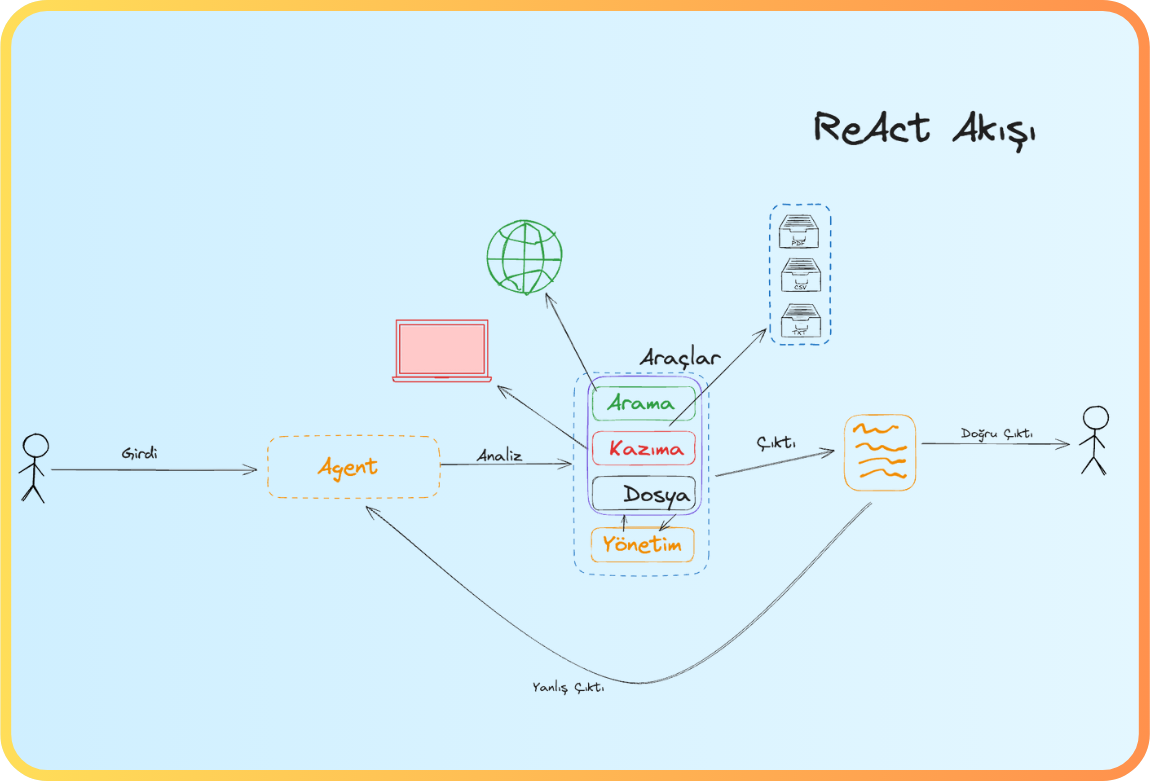

ReAct: Dil Modellerinde Akıl Yürütme ve Eylemi Birleştirme (07.11.2025)

-

Yazılım Testinin Yapay Zekâ ile İmtihanı (19.08.2025)

-

Yapay Zekâ Destekli Kod İyileştirme: SonarQube ve MCP (01.08.2025)

-

RestAssured ile API Testlerinin Otomasyonu (26.07.2025)

-

Regresyon Testi Gerekli mi? (06.06.2024)

-

Birim Test Nedir? Nasıl Yapılır? (17.10.2023)

-

Etkili Test Senaryoları Nasıl Yazılır? (17.07.2023)

-

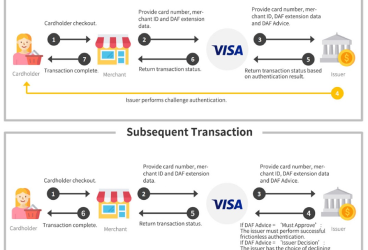

Sanal POS İşlemlerinde VISA Dinamik Kimlik Doğrulama (06.04.2024)

Önceki

Önceki